搜索引擎爬行规则分析:让网站更容易被发现

在互联网时代,网站的重要性越来越突出。对于企业而言,拥有一个易于被搜索引擎找到的网站,是至关重要的。但如何让搜索引擎更好地爬行你的网站,让你的网站得到更好的曝光呢?本文将从分析搜索引擎爬行规则入手,为你呈现一篇实用的指南。

一、爬行规则的定义与作用

二、网站可访问性对爬行规则的影响

三、页面质量是搜索引擎关注的重点

四、URL结构和内链布局的重要性

五、页面内容中关键词的密度和分布

六、标题标签和描述标签的作用

七、图片和视频的优化与利用

八、网站结构化数据的使用

九、站点地图对搜索引擎爬行的作用

十、外部链接的数量和质量对SEO的影响

十一、社交媒体平台的利用与优化

十二、新闻稿和博客的作用

十三、网站速度和移动设备适应性的重要性

十四、黑帽SEO的危害

十五、SEO策略的更新和优化

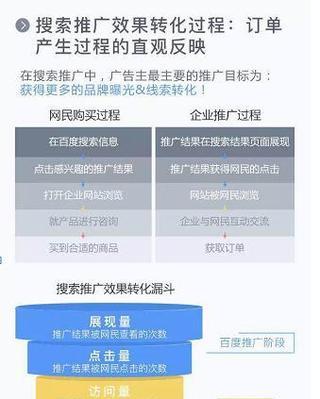

一、爬行规则的定义与作用

搜索引擎爬行规则,是指搜索引擎对网站进行爬行的标准和规定。爬行规则的作用是保障搜索引擎的高效运转,同时也为网站提供了一些优化的方向。

二、网站可访问性对爬行规则的影响

网站可访问性是指搜索引擎能够在没有障碍的情况下访问你的网站。如果网站存在访问性问题,搜索引擎会将这些问题视为网站质量低下的标志。

三、页面质量是搜索引擎关注的重点

页面质量是指页面内容、布局和设计的质量。高质量的页面内容和布局能够提升用户体验,同时也能够获得更多搜索引擎的关注。

四、URL结构和内链布局的重要性

URL结构和内链布局是指网站中的链接结构和链接数量。这些链接能够为搜索引擎提供更好的爬行路径,同时也能够提升用户体验。

五、页面内容中关键词的密度和分布

页面内容中的关键词密度和分布,是指页面内容中关键词出现的频率和位置。合理的关键词密度和分布能够提升页面的排名和曝光率。

六、标题标签和描述标签的作用

标题标签和描述标签是指在页面源代码中的标题和描述信息。这些信息能够为搜索引擎提供关键词和网站信息,同时也能够为用户提供更好的浏览体验。

七、图片和视频的优化与利用

图片和视频的优化和利用,是指为这些媒体提供高质量的标题、描述和标签,以便搜索引擎对这些媒体进行识别和索引。同时,这些媒体也能够为网站提供更好的用户体验。

八、网站结构化数据的使用

网站结构化数据是指在网站源代码中添加的特殊标记,以便搜索引擎更好地理解网站内容。这些数据能够提升页面排名和曝光率。

九、站点地图对搜索引擎爬行的作用

站点地图是一种特殊的文件,包含了网站所有页面的链接列表。这个文件能够帮助搜索引擎更好地爬行网站,并且提供更好的用户体验。

十、外部链接的数量和质量对SEO的影响

外部链接是指来自其他网站的链接。这些链接能够为网站提供更好的曝光率和排名,但是需要注意这些链接的数量和质量。

十一、社交媒体平台的利用与优化

社交媒体平台是一个重要的SEO工具,能够为网站提供更多曝光和链接。合理地利用和优化这些平台,能够为网站带来更好的流量和用户体验。

十二、新闻稿和博客的作用

新闻稿和博客是提升网站曝光率和排名的有效方式。通过发布高质量的新闻稿和博客,能够为网站带来更好的关注度和流量。

十三、网站速度和移动设备适应性的重要性

网站速度和移动设备适应性,是指网站在不同设备上的加载速度和显示效果。这些因素能够影响用户的体验和搜索引擎的排名。

十四、黑帽SEO的危害

黑帽SEO是指一些违反搜索引擎规定的SEO技术。这些技术虽然能够为网站带来快速的曝光率和排名,但是会带来严重的SEO惩罚和损害。

十五、SEO策略的更新和优化

SEO策略需要不断地更新和优化,以适应搜索引擎不断变化的爬行规则和算法。保持SEO策略的时效性和科学性,才能够为网站带来长期的曝光率和排名。

通过本文的分析,我们可以看出,搜索引擎爬行规则对于网站的重要性。合理地利用搜索引擎的爬行规则,能够让网站更容易被发现,提升网站的曝光率和排名。同时,也需要注意搜索引擎不断变化的规则和算法,更新和优化SEO策略,才能够为网站带来长期的成功。

深入探讨搜索引擎的爬行规则

在当今的互联网时代,搜索引擎是人们获取信息的重要途径。而对于网站主人来说,让搜索引擎能够更好地爬行自己的网站,提高网站的曝光率和排名,也成为了重要的任务之一。搜索引擎如何进行爬行呢?本文将从多个方面详细介绍搜索引擎的爬行规则。

搜索引擎对网站的爬行频率

搜索引擎对网站的爬行频率是由多种因素决定的。其中一个重要因素是网站的更新频率。如果一个网站经常发布新内容,那么搜索引擎也会更频繁地来爬行这个网站。网站的质量和关键词排名也会影响搜索引擎的爬行频率。

搜索引擎对网站内链的抓取

内链指的是网站内部链接。搜索引擎在进行爬行时,会根据内链跳转到网站内部其他页面。良好的内链结构有利于搜索引擎爬行和索引整个网站。内链中的关键词链接也可以帮助搜索引擎更好地理解网站的主题。

搜索引擎对网站外链的抓取

外链指的是其他网站链接到本网站的链接。搜索引擎会根据外链来抓取和判断本网站的权重和重要性。如果一个网站拥有更多的高质量外链,那么搜索引擎会更倾向于对该网站进行高频率的爬行。

搜索引擎对网站结构的抓取

搜索引擎需要通过爬行来了解网站的结构。良好的网站结构有利于搜索引擎更快地抓取和索引网站中的内容。对于大型网站来说,合理的分类和目录结构也有助于搜索引擎更好地了解整个网站。

搜索引擎对网站Sitemap的抓取

Sitemap是一种文件,用于告诉搜索引擎网站的结构和内容。如果一个网站有Sitemap文件,搜索引擎会首先查找该文件,以便更好地了解网站的结构和内容。建立完整的Sitemap文件有助于搜索引擎更好地了解和爬行网站。

搜索引擎对网站Robots.txt的抓取

Robots.txt文件用于告诉搜索引擎哪些页面可以访问,哪些页面不应该被访问。网站主人可以通过Robots.txt文件来控制搜索引擎的爬行。如果一个网站的Robots.txt文件设置有误,那么搜索引擎可能无法访问网站中的部分内容,从而影响搜索引擎对该网站的了解和排名。

搜索引擎对网站元素的抓取

搜索引擎在爬行网站时,会根据网站中的元素来了解网站的主题和内容。元素包括页面标题、描述、关键词等。良好的页面元素设置有助于搜索引擎更好地理解网站的主题和内容。

搜索引擎对网站图片的抓取

搜索引擎在爬行网站时,也会抓取网站中的图片。优化网站图片也有利于搜索引擎更好地了解网站内容和主题。网站主人可以通过为图片设置合适的Alt标签和文件名来帮助搜索引擎更好地了解图片内容。

搜索引擎对网站重复内容的处理

如果一个网站存在大量重复内容,搜索引擎可能会将其视为垃圾站点或者作弊行为。网站主人需要尽量避免网站中出现重复内容,以免影响搜索引擎对网站的判断和排名。

搜索引擎对网站404错误页面的处理

如果一个网站存在大量404错误页面,搜索引擎可能会将其视为低质量站点或者作弊行为。网站主人需要尽量避免网站中出现404错误页面,以免影响搜索引擎对网站的判断和排名。

搜索引擎对网站速度的要求

搜索引擎认为,用户体验是非常重要的因素。如果一个网站加载速度过慢,可能会被搜索引擎降低排名。网站主人需要尽量优化网站速度,提高用户体验和搜索引擎排名。

搜索引擎对网站的安全要求

搜索引擎认为,用户隐私和安全是非常重要的因素。如果一个网站存在安全漏洞或者恶意软件,可能会被搜索引擎认为是危险的站点,从而降低排名。网站主人需要尽量保证网站的安全性。

搜索引擎对网站的移动友好性要求

搜索引擎认为,移动设备的使用已经非常普及。如果一个网站不能够适应移动设备的需求,可能会被搜索引擎降低排名。网站主人需要尽量优化网站的移动友好性。

搜索引擎对网站语言和地区的要求

如果一个网站是针对特定语言和地区的,那么搜索引擎也会根据这些因素进行排名。网站主人需要尽量优化网站针对的语言和地区,以获得更好的搜索引擎排名。

综上所述,搜索引擎对网站的爬行规则是非常复杂和全面的。网站主人需要从多个方面考虑,以便让搜索引擎更好地了解和爬行自己的网站。只有这样,才能够提高网站的曝光率和排名,获得更多的流量和收益。

生财有道

生财有道